电子发烧友网综合报道 2025年6月30日,华为正式宣布开源盘古70亿参数的稠密模型、盘古Pro MoE 720亿参数的混合专家模型及基于昇腾的模型推理技术,此举标志着华为在AI技术生态建设领域迈出关键一步,为全球开发者、企业及研究人员提供了强大的技术支撑。

华为此次开源行动涵盖三大核心板块:盘古Pro MoE 72B模型权重与基础推理代码已率先上线开源平台;基于昇腾的超大规模MoE模型推理代码同步开放;盘古7B稠密模型相关代码将于近期完成上线。开发者可通过华为开源社区(https://gitcode.com/ascend-tribe)获取完整技术资源,参与模型优化与生态共建。

作为70亿参数的紧凑型模型,盘古7B在保持高效推理能力的同时,显著降低部署门槛。其设计聚焦行业场景的快速适配,特别适合资源受限环境下的边缘计算应用,为中小企业提供高性价比的AI解决方案。

该模型采用创新性的分组混合专家架构(MoGE),通过动态激活机制实现160亿参数的高效利用。在SuperCLUE评测中,其以720亿总参数量达到59分,与千亿级模型持平,展现出“小参数量、大能力”的技术优势。基于昇腾AI计算平台的优化,单卡推理吞吐量达2300 Tokens/s,较传统架构提升4倍,支持384个专家并行推理的超级节点架构,更将算力利用率(MFU)提升50%以上。

华为通过开源构建开放创新生态,吸引全球开发者参与模型优化。目前,盘古大模型已形成覆盖数据管理、训练、部署的全生命周期工具链,支持企业定制化开发。这种“基础开源+商业增值”模式,既降低技术使用门槛,又通过商业发行版形成可持续的盈利路径。

在金融、制造、医疗等领域,盘古模型的动态负载均衡技术使云端推理成本降低30%,支撑高并发实时作业场景。基于MoGE架构的轻量化引擎,可适配昇腾系列芯片,使百亿级模型在边缘设备高效运行,为工业互联网、智能座舱等场景开辟新应用空间。

作为首个由亚洲企业主导的AI大模型开源项目,华为的实践正在改变国际技术竞争格局。通过Apache-2.0协议运营,盘古模型已吸引科大讯飞、中国科学院等1300家机构采用,推动中国AI技术从跟跑向并跑乃至领跑转变。

此次开源行动,是华为“把复杂留给自己,把简单留给客户”技术理念的生动实践。当72B模型的专家网络在昇腾超节点上高效运转,当7B模型的轻量化部署突破行业边界,中国AI产业正以开源为支点,撬动全球技术创新的新范式。

-

华为

+关注

关注

216文章

35343浏览量

257559 -

盘古大模型

+关注

关注

1文章

112浏览量

820

发布评论请先 登录

华为开发者大会2025(HDC 2025)亮点:华为云发布盘古大模型5.5 宣布新一代昇腾AI云服务上线

在阿里云PAI上快速部署NVIDIA Cosmos Reason-1模型

NVIDIA RTX 5880 Ada与Qwen3系列模型实测报告

【幸狐Omni3576边缘计算套件试用体验】CPU部署DeekSeek-R1模型(1B和7B)

利用英特尔OpenVINO在本地运行Qwen2.5-VL系列模型

阿里云发布开源多模态推理模型QVQ-72B-Preview

猎户星空发布Orion-MoE 8×7B大模型及AI数据宝AirDS

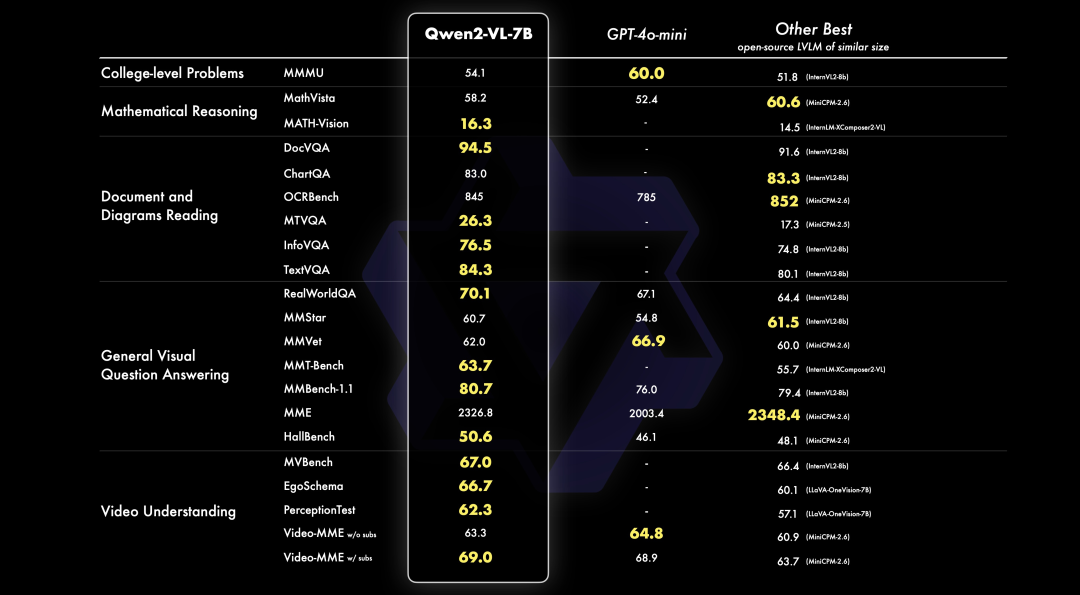

PerfXCloud重磅升级 阿里开源最强视觉语言模型Qwen2-VL-7B强势上线!

华为宣布开源盘古7B稠密和72B混合专家模型

华为宣布开源盘古7B稠密和72B混合专家模型

评论